💡 Arge optimistens funderingar: AI-utvecklingen har nått fas två

AI-utvecklingen har nått fas två, där vi skapar nytt baserat på vad vi lärt oss i fas ett. Kan kännas uppenbart, men förvånansvärt många hänger upp sig på nuvarande brister och bedömer framtiden helt fel.

Dela artikeln

Mina funderingar, tips och annat smått och gott som jag tror passar en faktabaserad optimist. För dig som är Premium Supporter hos Warp News, men det går fint att dela det med vänner och bekanta.

🤖 Fas två

Efter att ChatGPT släpptes i november 2022 så bestod AI-utvecklingen de kommande två åren i huvudsak av att använda mer träningsdata och fler processorer för att skapa bättre modeller. Förenklat beskrivet så var det mer av samma. Vi kan kalla det fas 1.

När människor började använda tjänsterna så kom vi gemensamt på att något som kallas chain-of-thought fick AI-tjänsterna att prestera bättre resultat. Alltså att en prompt som innehåller steg-för-steg-instruktioner. "Gör först X, sedan Y, sedan Z". Denna metod kunde leverera förbluffande bra resultat, som mer träffsäker finansanalys än mänskliga finansanalytiker.

Open AI lärde av detta och byggde in chain-of-thought i sina modeller och pratar nu om att alla modeller kommer vara så kallade reasoning models. Idén om AI som resonerar med sig själv är ungefär lika gammal som AI, men det var först när man såg styrkan i chain-of-thought som den byggdes in de stora språkmodellerna. Därmed kan man lansera nya tjänster, likt Deep Research som jag skrev om nyligen.

En annan utveckling är den DeepSeek stod för. Eftersom det är ett kinesiskt företag lider de brist på de allra bästa processorn, då USA har exportrestriktioner på dem. Det tvingade dem att vara kreativa och de kom på ett sätt att träna en AI-modell utan att använda så många och så bra processorer. De använde också styrkan i att AI-modellen kan resonera mig sig själv. Jag beskrev hur i den här texten.

Vi har därmed kommit in i fas två. Där nya idéer föds ovanpå det gamla. Så som utveckling alltid sker. Vi kommer på saker när vi använder tekniken och stöter på möjligheter och problem.

Detta kanske känns som den mest uppenbara spaningen någonsin, men förvånansvärt många hänger upp sig på nuvarande brister och tycks inte kunna se att de kommer lösas eller bli mindre. Baserat på det drar de långtgående och felaktiga slutsatser. "Det går aaaldriiiig", som vi säger i Närke.

Hallucinationer är det största problemet med stora språkmodeller. Det är ett problem som kommer att lösas. När och hur vet vi inte ännu, men på något sätt kommer det göras.

Mathias Sundin

Arge optimisten

❗ Annat smått och gott

📺 Suverän grundkurs i stora språkmodeller som ChatGPT

Andrej Karpathy var med och startade Open AI och ledde sedan utvecklingen av självkörande bilar på Tesla. Han går grundligt igenom hur en stor språkmodell skapas och fungerar, men på ett sätt som vi vanliga dödliga begriper.

😕 Uråldig pessimism

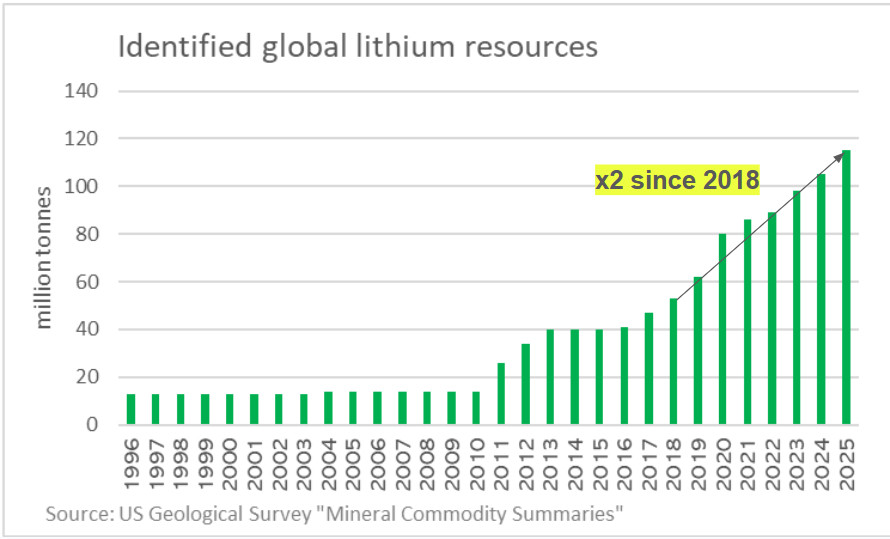

📈 "Vi kommer få slut på litium!"

Nej.

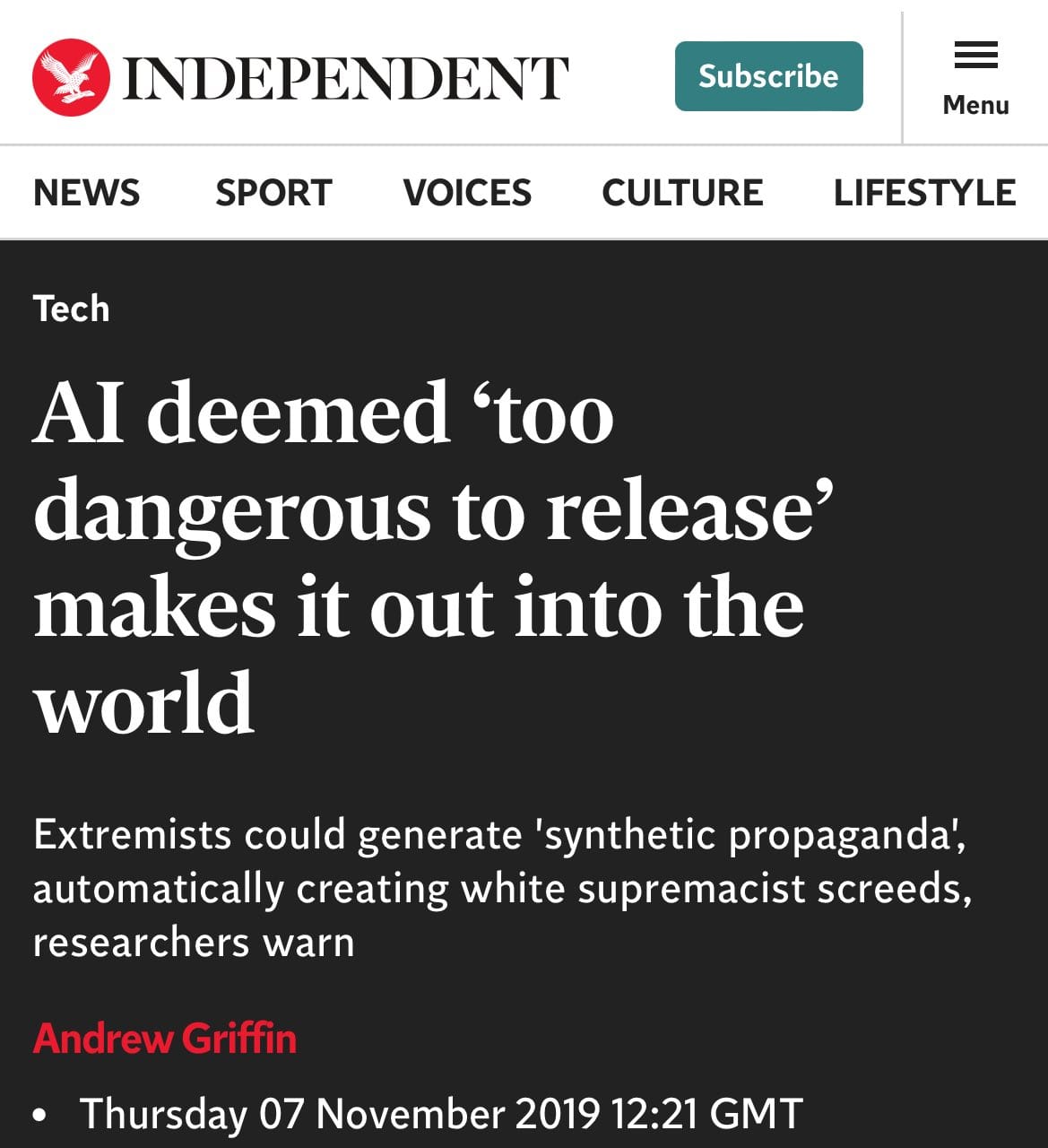

🤡 "För farlig för att släppa!"

Kom ihåg att 2019 menade man att GPT-2 var så kraftfull att den var farlig att släppa till allmänheten.

Nu är vi på GPT 4, med hundratals miljoner användare och farhågorna har inte förverkligats.

Mathias Sundin

Arge optimisten